Foto: Thomas Arnbo

Professor: Lærerne skal vide, hvor usikre testresultaterne er

Lærerne skal have at vide, hvor stor den statistiske usikkerhed er på hver enkelt elevs resultat i de nationale test. Hvis en elev har fået 37 point på skalaen, så skal læreren have at vide, at man kun med sikkerhed kan sige, at eleven ligger fx mellem 10 og 70 point, lyder det fra professor emeritus Svend Kreiner. Et nyt notat har vist store problemer med testenes målesikkerhed.

Bemærk

Denne artikel er flyttet fra en tidligere version af folkeskolen.dk, og det kan medføre nogle mangler i bl.a. layout, billeder og billedbeskæring, ligesom det desværre ikke har været teknisk muligt at overføre eventuelle kommentarer under artiklen.

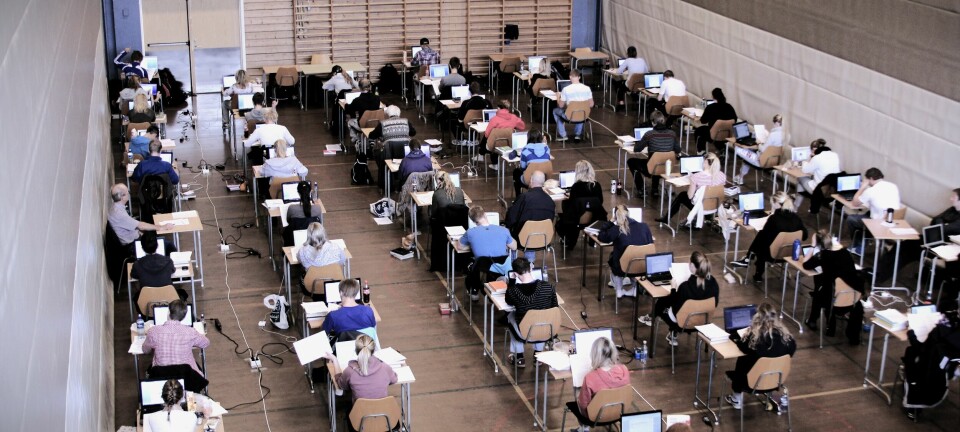

Elevers resultater i de nationale test er behæftet med statistisk usikkerhed. De er nemlig beregnet ud fra elevens besvarelser af et udtræk af opgaver. Ud fra om eleven svarer rigtig eller forkert på de udtrukne opgaver med forskelige beregnede sværhedsgrader, opgør testsystemet, hvordan eleven ligger placeret i forhold til en stor gruppe elever, der tog de nationale test i 2010. Den slags beregninger er behæftet med statistisk usikkerhed. Men når lærerne får elevernes resultater, og når de efterfølgende fortæller forældrene om dem, så står der ikke noget om, hvor mange gran salt resultatet bør tages med.

"Man bør naturligvis præsentere usikkerheden på hvert enkelt resultat - hvis en elev får 37 på percentilskalaen, skal læreren selvfølgelig have at vide, at det for eksempel svarer til et sted mellem 10 og 70. Så kan enhver se, at man skal være forsigtig med at konkludere", siger Svend Kreiner til folkeskolen.dk

Men så vil mange lærere måske mene, at hvis testene ikke er mere præcise end det, så er de er spild af tid?

"Det behøver det bestemt ikke at være. Den score man får er selvfølgelig det bedste gæt, men nogle elever vil ligge skævt af statistiske årsager. Testresultater må aldrig stå alene - lærerne kender deres elever og kan bruge testene til at få bekræftet, hvad han eller hun allerede ved. Eller man kan få et overraskende resultat, og så vil det være naturligt at bede eleven tage testen en gang til", siger Svend Kreiner.

Testene sorterer ikke godt nok

Stod det til Kreiner var de nationale test udelukkende det redskab til lærerne, de oprindelig var tænkt til - ikke hverken information til forældrene eller - som det er sket med folkeskolereformen - et redskab til at måle, om skoler og kommuner lever op til nationale mål. Jo større vægt, samfundet lægger på testresultaterne, jo større bliver risikoen for, at lærerne føler sig presset til at træne elevene op til testene - og jo mere usikker og misvisende bliver målingen.

Den er gal med den såkaldte reliabilitet, i de nationale test, konkluderer Svend Kreiner i lighed med sin professorkollega Peter Allerup efter at have læst en ny analyse fra Styrelsen for It og Læring. Styrelsen har gennemgået over 30.000 elevers resultater efter at Folkeskolen beskrev, hvordan elevernes resultater svingede, som vinden blæser på Ørum Skole på Djursland. På landsplan viser det sig, at omkring 12 procent af eleverne har større udsving end ventet, når de tager den samme test to gange med kort tids mellemrum.

"Da reliabiliteten først og fremmest er et spørgsmål om hvor sikkert testene kan skelne mellem dygtige og mindre dygtige elever betyder det at disse test ikke er gode nok til at sortere elevene efter, hvor dygtige de er og derfor at de såkaldte percentil-værdier er for usikre. Der findes to måder at tjekke reliabiliteten på. Man kan, som ministeriet har gjort, kigge på forskellen på første og anden test hos elever, der har taget den samme test to gange. Det kan være påvirket af, at der for nogle af elevernes vedkommende er gået en måned i mellem, og elevene må formodes at blive dygtigere af at gå i skole i en måned. Men der er en anden formel, og hvis den også viser lige så store problemer, så er testene for usikre", siger Svend Kreiner og anbefaler altså, at ministeriet tester realibiliteten ed nye beregninger for at se, om der er andre årsager til udsvingene, end at eleverne er blevet dygtigere.

Nationale test: 12 procent af eleverne svinger overraskende fra test til test

Genbrugsopgaver

Én medvirkende årsag kan være, at eleverne møder de samme opgaver igen i alt for stort omfang. "Det er nødvendigt og formodentlig enkelt at lægge ind i systemet, at den samme elev ikke må få den samme opgave igen", siger Svend Kreiner. En særlig problemstilling gør sig gældende for det gamle test-smertensbarn, læseafkodning i 6. og 8. klasse, hvor eleverne så at sige tømmer banken, fordi de for længst har automatiseret deres læsning.

Hvis sværhedsgraden ikke stemmer

Men det store problem, som kan være årsag til, at testene simpelthen ikke længere måler sikkert, er at opgavernes beregnede sværhedsgrad ikke stemmer med, hvor svære de faktisk er for eleverne at løse. Hvis den ikke gør det, falder hele systemet til jorden. "Det er standardrutine i forbindelse med pædagogiske test, at man forholdsvis regelmæssigt afprøver, om sværhedsgraderne har ændret sig", fremhæver Svend Kreiner. "Det kan skyldes, at der er ord eller begreber, som ikke længere bruges, og som der derfor er færre elever, der forstår. Eller det kan skyldes, at man er begyndt at træne eleverne i bestemte opgavetyper, som vi har set med ordkædeopgaverne. Så passer den sværhedsgrad, de blev beregnet til i 2010, ikke længere", fremhæver Svend Kreiner og appellerer ligesom Peter Allerup til, at testene får et meget grundigt serviceeftersyn.